ChatGPT, l’épopée bringuebalante de l’IA, technologie aux contours flous

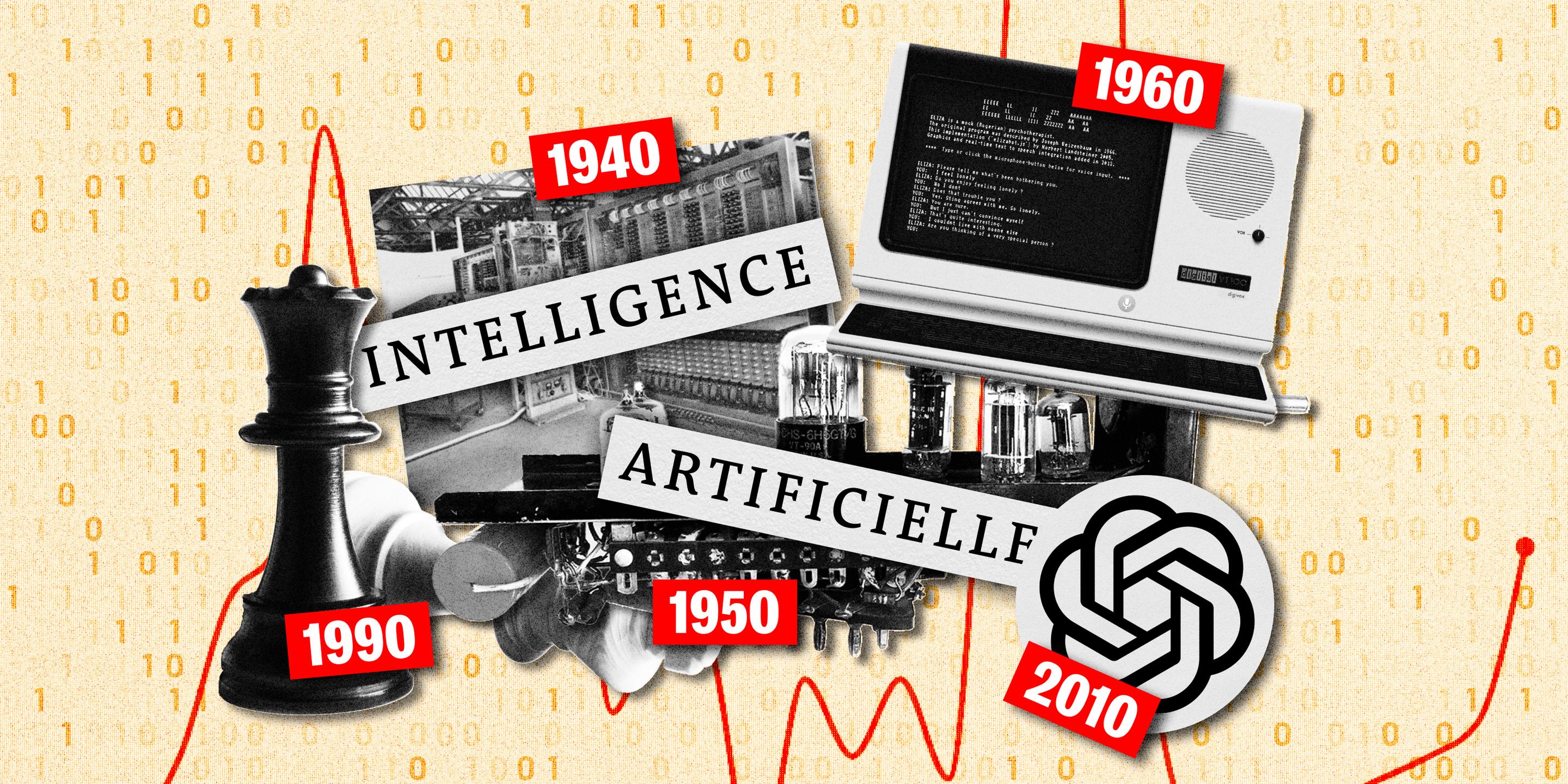

Depuis les années 1940, le sens des termes intelligence artificielle a beaucoup évolué, à mesure que ses usages se développaient et que ses mécanismes se perfectionnaient. Radiographie, décennie par décennie.

Sur un forum Internet, un étudiant, un brin perdu, pose une question pas si bête : « La définition de l’IA [intelligence artificielle] a-t-elle changé ? » Un autre lui répond, sur un ton désabusé : « J’ai fini par ne plus considérer ce mot comme un terme académique que je peux employer (…) Il pourrait ne pas être clair pour mon lecteur. »

L’emploi des termes intelligence artificielle n’a effectivement pas toujours brillé par sa constance. Les spécialistes s’accordent généralement sur un début de définition : une IA est une machine capable de réussir des tâches qu’on croyait jusqu’alors réservées à l’intelligence humaine. « Mais qu’est-ce que l’intelligence humaine ? », questionneAnne Laurent, chercheuse en informatique, directrice de l’antenne Inria de l’université de Montpellier. « Les philosophes, les ingénieurs et les cogniticiens ne sont pas d’accord. Sa définition change selon les époques. »

Si l’on observe l’histoire de l’« IA » au sens large, c’est peut-être au XIXe siècle que la première compétence de l’intelligence humaine tombe, conquise par les machines à calculer capables de multiplier et diviser. Mais une définition plus restreinte prévaut souvent, faisant naître l’IA dans les années 1940 avec l’apparition de l’ordinateur.

1940 : le socle

L’un des tout premiers ordinateurs électroniques, le Colossus, est employé par l’armée britannique pour casser les communications chiffrées du haut commandement allemand. Il est beaucoup plus puissant que les machines électromécaniques qui l’ont précédé. Celles qui lui succéderont seront plus faciles à programmer, faisant tourner des algorithmes complexes et variés, rendant enfin possible l’expérimentation des théories sur les machines « pensantes » qui commencent à flotter dans l’air – Pitts et McCulloch imaginent dès 1943 le principe des neurones artificiels, un modèle simplifié du fonctionnement des neurones humains.

Mais comment nommer ce champ naissant ? Les termes « intelligence artificielle » n’existent pas. La presse parle de cerveau mécanique ou électronique, voire de cybernétique, termes vastes, agrégeant le tir automatisé ou le pilotage des feux rouges. Les scientifiques, eux, ont chacun leur vocable – Turing parlant notamment de « machine avec intelligence ».

1950 : tous azimuts

C’est la décennie du foisonnement expérimental et théorique, à Paris comme aux Etats-Unis, lors de laquelle des chercheurs posent les bases des deux grandes familles d’IA. Les IA logiques simulent l’intelligence en exécutant des algorithmes mis au point par des chercheurs : en 1956, Simon, Shaw et Newell conçoivent une machine capable de résoudre des problèmes mathématiques en imitant la logique humaine, le General Problem Solver.

L’autre famille est celle des neurones artificiels. En 1951, Marvin Minsky conçoit le premier réseau opérationnel, le Snarc, qui apprend par récompenses. En 1959, le réseau neuronal d’Arthur Samuel se forme aux dames en jouant contre une autre version de lui-même, conservant l’IA gagnante, afin de jouer la prochaine partie. Le principe-clé du machine learning est né. Les dames, les échecs, la traduction sont les terrains de jeu des chercheurs. Certains espèrent bâtir des applications commerciales en quelques années : elles mettront des décennies à émerger.

Au milieu de la décennie, les principaux pionniers de l’IA se réunissent au Dartmouth College, près de Boston (Etats-Unis), autour d’une croyance commune : « Chaque aspect de l’apprentissage, ou de toute autre manifestation de l’intelligence, peut être décrit si précisément qu’on peut faire en sorte qu’une machine le simule. » L’expression « intelligence artificielle » naît à cette occasion.

1960 : les règles et la logique

Le mot IA n’apparaît ni dans le film de Stanley Kubrick 2001 : l’odyssée de l’espace, ni dans les colonnes du Monde, qui lui préfère encore « cerveau électronique », objet d’un nombre croissant d’articles. On l’imagine prévoir la météo, les élections, l’issue des conflits, piloter avions et systèmes financiers.

Dans les labos, les IA logiques montent à l’avant-scène. Le robot conversationnel Eliza simule les réponses d’un psychologue en rebondissant adroitement sur des mots-clés : si son interlocuteur tape « mère », l’IA répond souvent « dites-en moi plus sur votre famille ». Edward Feigenbaum pose les bases des « systèmes experts », dont l’ambition est de transformer l’expertise d’un groupe de spécialistes en une base de connaissances constituée de règles enchevêtrées. N’importe qui peut ensuite l’interroger pour obtenir une réponse experte. Quelques années plus tard, le système expérimental Mycin, composé de 600 règles, diagnostique les maladies infectieuses, classées par ordre de probabilité.

Les systèmes experts sont-ils de vraies IA ? Beaucoup d’observateurs en sont convaincus, même dans le camp de ceux qui ne rangent pas les programmes informatiques ordinaires dans cette case. « Selon le contexte, ces systèmes piochaient des règles différentes : leurs raisonnements étaient variables », se souvient Jean-Gabriel Ganascia, chercheur en informatique et auteur de nombreux livres sur l’IA.

1970 : le premier hiver

Devant le décalage entre les promesses et les résultats, les financements se resserrent : c’est le premier hiver de l’IA – au moment même où la technologie commence à sortir des labos. Le calcul se démocratise grâce aux calculatrices à bas coût, les systèmes experts pénètrent des entreprises pionnières, les traducteurs automatiques sont expérimentés dans de grosses administrations. Le terme IA perce enfin dans Le Monde et le New York Times – timidement : il n’est encore question que de recherche et de compétitions d’échecs entre scientifiques.

Etrangement, les premiers jeux vidéo d’échecs destinés aux ordinateurs personnels, eux, ne reçoivent pas le label « intelligence artificielle », ni dans les colonnes du Monde, ni dans les publicités et manuels des premiers jeux (Sargon, Microchess, Videochess, Cyrrus) dans lesquels on croise pourtant les mots « pensant » ou « algorithme ». Pourquoi se prévaloir d’une expression si peu utilisée par le grand public ?

1980 : l’euphorie

L’IA finit pourtant par rentrer dans le langage courant, à la faveur de l’explosion des systèmes experts. C’est de loin la famille d’IA la plus citée dans Le Monde cette décennie-là. Les recherches scientifiques, ultra-dominantes la décennie précédente, ne représentant plus que la moitié des articles du journal. Dans les magazines de jeux vidéo naissants, le terme apparaît pour qualifier le comportement des personnages ennemis.

Dans les laboratoires, les réseaux de neurones connaissent un deuxième printemps. Plusieurs équipes posent les jalons des réseaux neuronaux à couches superposées. Geoffrey Hinton leur apprend à revenir en arrière à travers les couches traversées pour corriger leurs erreurs. Yann Le Cun conçoit l’une des premières applications réelles, un automate de lecture des codes postaux sur les chèques qui sera utilisé par les banques. A San Diego, en 1987, un millier de chercheurs se réunissent pour échanger sur les réseaux neuronaux.

1990 : le second hiver

Aussi vite disparus qu’apparus, les systèmes experts s’évanouissent des colonnes du Monde. Leur poids est divisé par sept dans les publications en langue anglaise indexées par Google Books. Leur objectif était de mettre des expertises en équation : beaucoup leur ont résisté. Ces systèmes auront des descendants sous des appellations moins clivantes : scripts d’appel des SAV, systèmes de gestion du savoir des grandes entreprises, etc. Ce naufrage, combiné aux difficultés de la traduction automatique, annonce le deuxième hiver de l’IA.

D’autres systèmes imitant l’intelligence humaine émergent sans revendiquer l’étiquette IA. Le credit scoring s’impose, avalant des informations financières sur un particulier réclamant un emprunt, puis produisant une note de solvabilité pour aider le banquier. « L’IA avait mauvaise presse à cette époque, on évitait de s’en revendiquer » se souvient Jean-Gabriel Ganascia. Les concepteurs de pilote automatique pour les avions civils n’endossent pas non plus ce label. Anne Laurent l’explique par « les craintes générées par l’IA dans la science-fiction », Jean-Gabriel Ganascia par « la réputation des IA, qui donnent une approximation, ou une probabilité plutôt qu’une réponse mathématiquement exacte ».

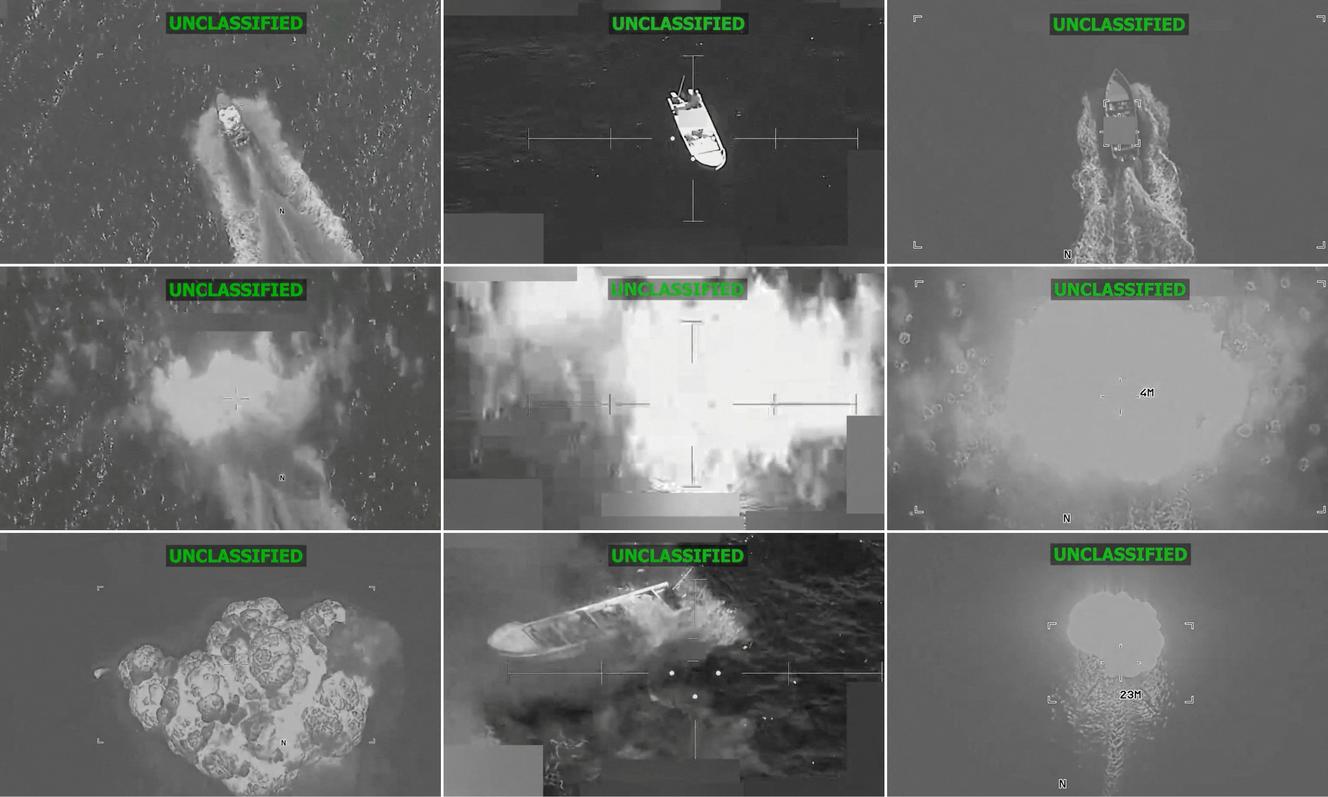

Dans les labos, le bouillonnement perdure. Les neurones artificiels apprennent à garder la trace de leurs états précédents, ce qui les aide à traduire en fonction du contexte. Les IA non neuronales progressent aussi, les « machines à vecteur de support », montrant, dans bien des domaines, des résultats supérieurs. La fin de la décennie est marquée par une opération marketing : IBM aligne son IA Deep Blue contre le champion d’échecs Garry Kasparov. Le robot gagne, c’est la chute d’un symbole de l’intelligence humaine. Le terme IA est désormais gravé dans tous les esprits. Les robots d’IBM affronteront plus tard les traders, puis le jeu TV Jeopardy.

2000 : la veillée d’armes

L’hiver se prolonge. Des journaux scientifiques refusent des publications sur les réseaux neuronaux, des experts comme Léon Bottou et Yann Le Cun, découragés, délaissent provisoirement la discipline. Mais la recherche ne s’arrête pas, et une pièce manquante du puzzle se met en place : l’Internet est désormais suffisamment vaste pour fournir une énorme masse de données annotées sur lesquels les IA pourront s’entraîner.

Dans les colonnes du Monde, les applications commerciales ont presque disparu. Il n’est plus question que de recherches, sur la culture des tomates ou la reconnaissance d’émotions par exemple. Pourtant, l’IA continue de déboucher sur des applications concrètes, dans l’éducation notamment, ou l’« adaptive learning » tente de distribuer à chaque élève la bonne brique d’apprentissage au bon moment.

2010 : la déflagration

Tout à coup, l’IA neuronale passe de l’hiver arctique à l’été équatorial. En 2011, Apple lance son assistant personnel Siri. En 2012, le réseau neuronal ImageNet bat un record de reconnaissance d’images. La reconnaissance de la parole et la traduction franchisent des caps significatifs. Des applications comme l’analyse de la fraude, la biologie moléculaire, l’imagerie médicale, l’embellissement des images font des avancées-clés. Les chercheurs en réseaux neuronaux deviennent la proie des chasseurs de têtes.

Dans l’euphorie, on appelle « IA » tout et n’importe quoi. La motricité des robots à deux, quatre ou six pattes est ainsi labellisée, sans pour autant simuler l’intelligence humaine. Anne Laurent tente de comprendre pourquoi : « Cette motricité s’est développée grâce aux réseaux neuronaux. Et puis c’était un défi qui résistait à l’intelligence humaine. » Dans d’autres cas, l’usage du terme IA flirte avec la manipulation. Le « gendarme » boursier américain traîne en justice une firme d’investissement vantant une IA qui n’existe pas. Coca-Cola affirme que sa nouvelle formule a été créée par IA sans en apporter la preuve.

Dans les labos de Google, une seconde déflagration se profile en 2017 : huit chercheurs conçoivent la dernière brique nécessaire à l’avènement de ChatGPT, les « transformers », qui permettent à l’IA de regarder le contexte autour d’un mot, plutôt que de parcourir les mots l’un à la suite de l’autre.

2020 : seconde déflagration

ChatGPT est commercialisé fin 2023 : le monde découvre un robot conversationnel meilleur qu’un humain à l’art de répondre à n’importe quelle question de culture générale et scientifique. En mars 2025, des chercheurs de l’université de San Diego lui font passer le test imaginé par Alan Turing en 1950 : « Le robot doit communiquer avec des personnes pendant cinq minutes en leur faisant faire croire qu’il est humain dans au moins 30 % des cas », explique Jean-Gabriel Ganascia. Selon les chercheurs, dont l’article n’a pas encore revu par des pairs, ChatGPT 4.5 y parviendrait 73 % du temps.

Dans la foulée, des générateurs d’images, de chansons et de vidéos émergent. C’est la consécration pour les réseaux neuronaux, considérés comme la plus noble famille d’IA, la plus proche du fonctionnement du cerveau humain et de sa capacité à s’autoformer – complexe au point que les chercheurs comprennent très mal comment ces neurones se nouent et communiquent.

Mais la mécanique des robots conversationnels demeure éloignée de la complexité d’un cerveau, et il se trouve encore des voix pour soutenir mordicus qu’il ne s’agit pas véritablement d’intelligence artificielle. A l’inverse, pour d’autres, la machine est désormais entrée de plain-pied dans l’ère de l’intelligence. « Ce sont les observateurs qui en parlent avec le plus de certitude qui me font le plus peur », commente Anne Laurent.

« Il faudra apprendre à vivre avec plusieurs définitions et savoir s’aligner sur celles des autres. » Tout en gardant un œil sur les mutations du terme : « Ces derniers temps, le mot IA tend à être réservé aux IA génératives », qui n’en sont pourtant que l’avatar le plus récent, observe Jean-Gabriel Ganascia. La langue est un organisme vivant, on peut difficilement empêcher les mots de changer de sens au fil du temps.

[Source: Le Monde]