Diagnostic médical : quand l’intelligence artificielle se met à raisonner comme un médecin

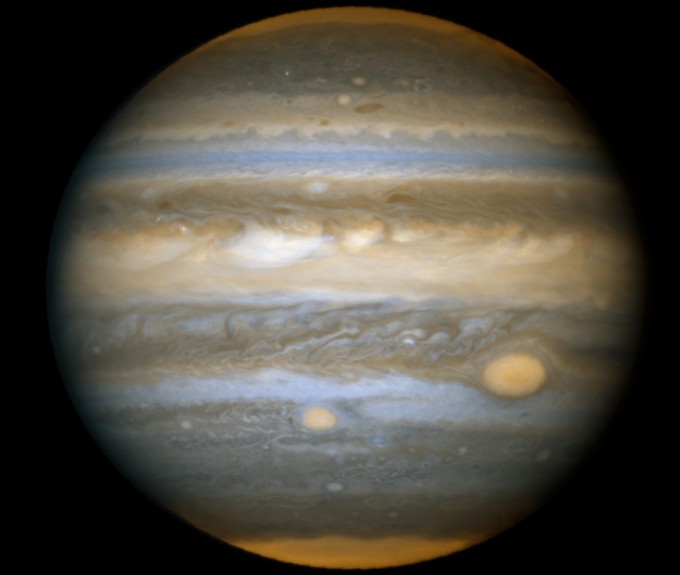

Confrontée à des cas complexes, l’IA dépasse le plus souvent le clinicien dans l’exercice du diagnostic différentiel, cette étape clé où le médecin énumère et hiérarchise les causes possibles d’un tableau clinique.

Tout médecin le sait : poser un diagnostic est une affaire de raisonnement. Face à un patient, il faut examiner, ausculter, interroger, interpréter, afin d’envisager plusieurs causes possibles pouvant expliquer la pathologie avant d’en retenir une. Ce processus conduit à ce qu’on appelle le diagnostic différentiel : la liste des maladies susceptibles d’expliquer les symptômes cliniques observés, puis les hiérarchiser selon leur cohérence et leur probabilité. Cet exercice de pensée mobilise la connaissance, la mémoire, l’expérience, et parfois l’intuition. Or, ce sont précisément ces facultés que chercheurs et ingénieurs informaticiens tentent aujourd’hui de transmettre à des systèmes d’intelligence artificielle (IA).

L’évolution récente des systèmes experts et des algorithmes d’aide au diagnostic bouleverse progressivement la démarche traditionnelle du clinicien, désormais confronté à une masse exponentielle de données et à l’exigence de décisions rapides et exactes. Ce défi est particulièrement aigu dans le domaine du diagnostic différentiel, où la subtilité du raisonnement clinique, la capacité à relier des indices disparates et à replacer chaque donnée dans l’histoire singulière d’un patient demeurent le cœur du métier de clinicien.

Plusieurs études récentes se sont penchées sur cette question : jusqu’où une machine peut-elle raisonner comme un médecin ? Peut-elle analyser et interpréter les données d’un dossier clinique, puis établir par écrit un diagnostic différentiel cohérent ?

Pour y répondre, des chercheurs de l’université de Californie San Francisco et de la faculté de médecine de Harvard (Boston) ont jugé utile de placer l’humain et l’IA, à égalité, devant un même cas clinique complexe. Les résultats de leur étude ont été publiés le 9 octobre 2025 dans l’hebdomadaire médical américain The New England Journal of Medicine (NEJM). Elle éclaire la façon dont l’homme et la machine raisonnent pour parvenir au diagnostic.

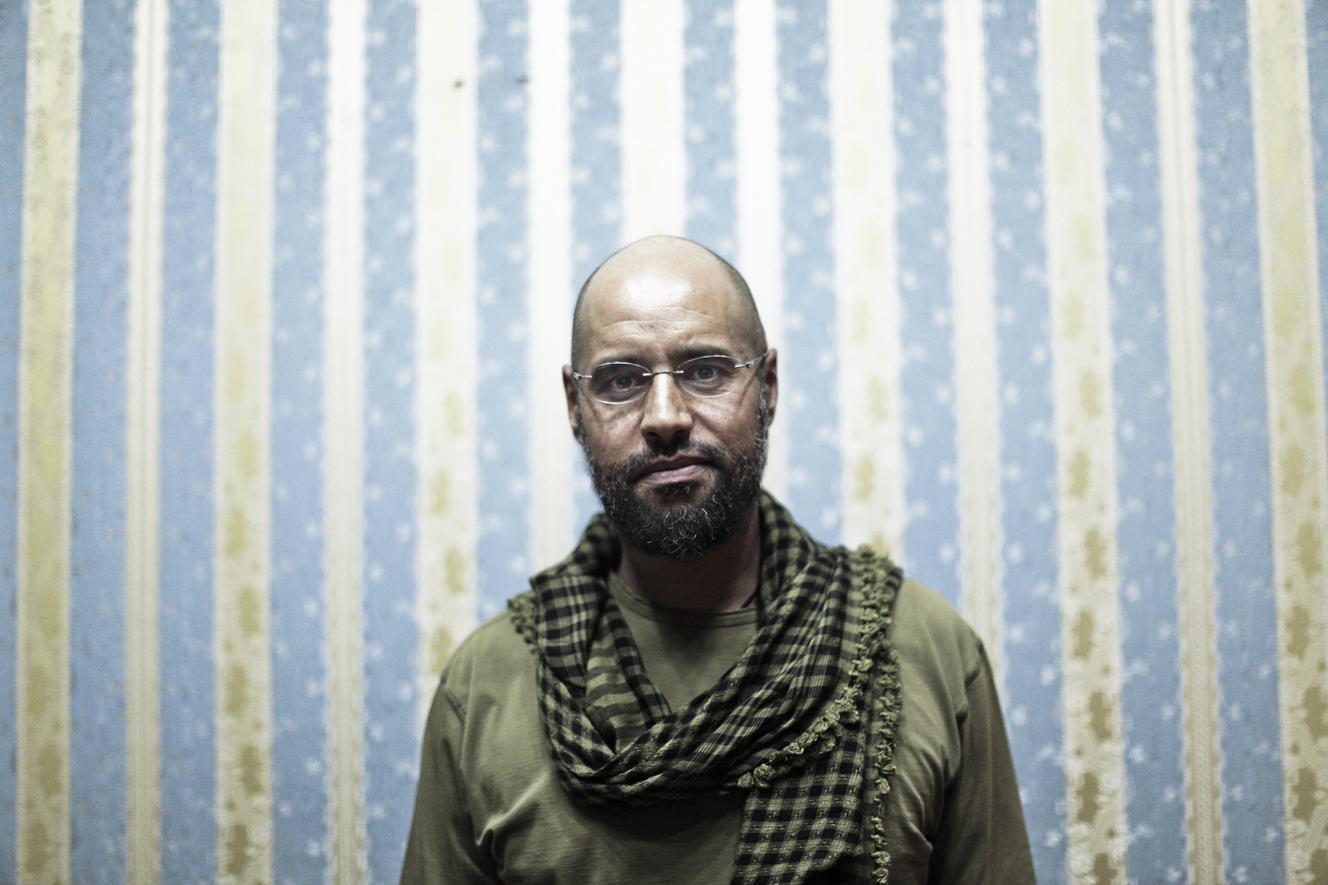

L’homme, c’est le Dr Gurpreet Dhaliwal, professeur de médecine à l’université de San Francisco, reconnu pour son expertise en raisonnement clinique, un véritable Dr House dans la vie réelle. La machine, baptisée « Dr CaBot », a été entraînée sur des milliers de cas cliniques réels. Son nom rend hommage au Dr Richard C. Cabot, fondateur de la célèbre rubrique des cas cliniques : les Case Records du Massachusetts General Hospital, publiés sans interruption par le New England Journal of Medicine depuis 1923.

Confronter médecin et IA sur un même cas

Pour la première fois, un médecin expert et une IA ont été confrontés au même cas clinique, chacun développant son raisonnement sans connaître celui de l’autre, afin d’évaluer objectivement leurs capacités respectives. Les auteurs précisent qu’il s’agissait du premier cas jamais confié à Dr CaBot pour analyse. Le texte généré par l’IA a été publié dans le NEJM tel quel, sans aucune correction ni réécriture, y compris les références bibliographiques sélectionnées par la machine.

Le cas en question met en scène un homme de 36 ans, alcoolodépendant, hospitalisé pour des douleurs abdominales et lombaires, une fièvre persistante, de la diarrhée, des vomissements, une hypoxémie (diminution du taux d’oxygène dans le sang) et une thrombopénie (baisse du nombre de plaquettes).

À l’examen clinique : hypotension, ictère (jaunisse) et anomalies à l’auscultation pulmonaire. Les analyses biologiques révèlent un état inflammatoire marqué et une infection à Streptococcus anginosus.

L’imagerie révèle des opacités pulmonaires multiples, un foie volumineux, un

épaississement du duodénum (partie initiale de l’intestin grêle), une obstruction (thrombose) partielle de la veine rénale droite s’étendant jusqu’à la veine cave inférieure et ce qui semble être une communication anormale entre le duodénum et le rein droit.

Le raisonnement du clinicien

Comme tout expert, le Dr Dhaliwal intègre l’ensemble des signes cliniques, biologiques et radiologiques pour bâtir un schéma causal. Il hiérarchise ses hypothèses, cherchant à relier les anomalies infectieuses, vasculaires, hépatiques et pulmonaires, pour finalement identifier une cause unique susceptible d’expliquer l’ensemble du tableau clinique.

Face à ce patient de 36 ans atteint d’une infection généralisée et de multiples atteintes, le Dr Gurpreet Dhaliwal se rend rapidement à l’évidence : aucune hypothèse diagnostique convaincante ne saurait rendre compte de l’ensemble des anomalies sans minimiser l’une ou l’autre des manifestations majeures. Il estime qu’une telle approche ne serait ni logique, ni justifiée. Il décide alors d’opter pour une stratégie plus appropriée à la complexité du tableau clinique : reconstituer une chaîne causale, une histoire médicale cohérente où chaque trouble s’enracine logiquement dans le précédent.

Tout commence par une infection à Streptococcus anginosus. Cette bactérie est habituellement présente dans l’oropharynx, à l’arrière de la cavité buccale. Elle a pu pénétrer dans le sang à la faveur d’une lésion digestive. Rapidement, l’hypothèse d’une brèche intestinale s’impose : les examens révèlent un épaississement du duodénum, signe d’inflammation locale. Cette anomalie s’accompagne de deux complications : un abcès entre le duodénum et le pôle supérieur du rein droit, et la formation d’un caillot infecté dans la veine rénale droite, propagé ensuite jusqu’à la veine cave inférieure, la grande veine centrale qui ramène le sang du bas du corps vers le cœur.

Le médecin explore d’autres pistes : ischémie mésentérique (interruption du flux sanguin intestinal), maladie de Crohn, tumeur du duodénum, infection parasitaire… mais aucune ne colle parfaitement au tableau. Survient alors une anomalie pulmonaire : des opacités suspectes aux poumons. Ce pourrait être le chaînon manquant. Après avoir écarté des causes rares - embolies septiques (migration de caillots infectés), endocardite (infection du cœur), strongyloïdose (parasitose due à un ver) -, il retient l’explication la plus probable : une pneumonie d’aspiration, suite à une fausse route lors d’un épisode d’ivresse aiguë. Le patient aurait vomi en état d’altération de conscience liée à l’alcool.

Plutôt que de voir les deux atteintes, digestive et pulmonaire, comme indépendantes, le Dr Dhaliwal privilégie l’hypothèse unificatrice : chez ce jeune adulte, l’alcool est le facteur commun reliant l’inflammation intestinale à la pneumonie d’aspiration. Selon lui, c’est là que réside la clé du diagnostic. « Établir une chaîne causale oblige à se demander non seulement ce qu’il s’est passé, mais aussi pourquoi. Comment la consommation d’alcool peut-elle conduire à une fausse route ? », écrit le médecin dans son compte rendu, soulignant le rôle délétère de l’alcool sur la vigilance et les réflexes protecteurs, comme la toux ou le réflexe nauséeux.

Il s’interroge : « Introduire cette étape intermédiaire dans la chaîne des causes ouvre la voie à un raisonnement par analogie : si l’alcoolisation aiguë peut détourner les aliments vers les poumons, ne pourrait-elle pas aussi orienter par erreur des objets non alimentaires vers le tube digestif ? ». Il poursuit : « Parmi les objets couramment avalés accidentellement figurent les pièces de monnaie, les piles, les épingles, les aiguilles ou les bijoux ; mais ces objets métalliques sont généralement visibles à la radiographie. De même, les petites arêtes de poisson ou d’oiseau peuvent perforer l’intestin, mais elles apparaissent souvent à l’imagerie en raison de leur calcification. En revanche, un corps étranger d’origine végétale pourrait passer inaperçu ».

Cette intuition conduit le clinicien à suspecter un objet banal, présent à table, anodin en apparence mais dangereux une fois avalé : le cure-dents. « Le suspect le plus probable est un cure-dents en bois, un objet banal, utilisé dans les sandwichs ou pour l’hygiène dentaire. L’ingestion d’un cure-dents passe souvent inaperçue, mais dès qu’elle est identifiée, elle constitue une urgence médicale, tant le risque de perforation viscérale et de lésion vasculaire est élevé ».

Dans ce cas précis, la douleur abdominale et dorsale apparue deux semaines avant l’hospitalisation correspond vraisemblablement au moment où le cure-dents a traversé le duodénum, avant de pénétrer dans l’espace rétropéritonéal et le rein. Il a alors créé un foyer d’infection à Streptococcus anginosus et permis le passage de la bactérie dans le sang. Une intoxication alcoolique concomitante (binge-drinking) a pu favoriser une fausse route responsable d’une pneumonie d’aspiration. Le médecin conclut logiquement : « Je préconiserais une endoscopie pour visualiser et retirer le cure-dents ».

Le raisonnement de l’IA

De son côté, l’IA Dr CaBot, à partir des mêmes données, élabore son diagnostic en mobilisant en quelques secondes une gigantesque base de connaissances médicales : des millions d’articles de la littérature médicale et dans plus de six mille cas cliniques. Environ cinq minutes lui suffisent pour produire un diagnostic différentiel détaillé et référencé, accompagné d’une vidéo de synthèse.

L’intelligence artificielle attire rapidement l’attention sur l’infection à S. anginosus, la propagation du germe par voie sanguine, et propose, elle aussi, l’hypothèse d’une plaie ou d’une perforation du duodénum compliquée d’un abcès rétropéritonéal, cause possible d’une thrombophlébite septique et d’emboles pulmonaires infectieux. Autrement dit, le diagnostic final du médecin et celui de la machine convergent presque parfaitement.

Trois jours plus tard, un nouveau scanner révèle la présence d’un corps étranger linéaire de 5,2 cm, ayant perforé le duodénum et traversé le pôle supérieur du rein droit. L’endoscopie permet de retirer un cure-dents en bois, intact, avalé par inadvertance deux semaines plus tôt. Après l’intervention, le patient a guéri rapidement sous traitement antibiotique et anticoagulant. Il a ensuite été suivi pour son addiction à l’alcool.

Quand un cure-dents met l’IA en défaut

L’intérêt majeur de cette étude ne réside pas seulement dans la résolution du cas

clinique, mais dans la rencontre entre deux formes d’intelligence, humaine et artificielle. Les auteurs ont volontairement publié dans la revue médicale les raisonnements bruts, sans correction, afin que le lecteur puisse juger par lui-même des forces et limites du raisonnement de l’IA.

« L’objectif de cet article était uniquement d’offrir aux lecteurs l’occasion de se familiariser avec l’usage potentiel de l’IA en médecine et dans la prise de décision clinique. Quant à savoir si l’IA a une place légitime dans ce domaine, il appartient au lecteur d’en juger », concluent Gurpreet Dhaliwal, Arjun Manrai, Thomas Buckley, Elizabeth Hohmann et leurs collègues.

Ce comparatif homme-machine souligne le contraste : le médecin excelle dans l’analyse contextuelle et la formulation d’hypothèses nouvelles, tandis que l’intelligence artificielle impressionne par sa rapidité à traiter une masse d’informations et à générer une liste de diagnostics plausibles. Mais malgré sa puissance analytique, l’IA n’a pas su trouver une explication pouvant relier tous les faits puisqu’elle n’a pas émis l’hypothèse de la présence d’un corps étranger.

Intuition humaine

Si l’IA sait assembler logiquement les données, l’intuition humaine fait la différence : seul le clinicien a évoqué la piste du cure-dents, établissant un lien qu’aucun algorithme n’aurait pu inférer. La machine raisonne par corrélations alors que l’humain raisonne par analogie, expérience et imagination. Lui seul parvient à donner du sens à l’histoire clinique. C’est sa capacité à raisonner par causalité, en mobilisant à la fois intuition et logique, qui lui permet d’évoquer la piste du corps étranger et de relier les symptômes entre eux.

Ce cas emblématique, qui met en lumière à la fois la convergence et la différence entre le raisonnement probabiliste de la machine et l’intuition critique du médecin, illustre surtout l’entrée de l’intelligence artificielle dans le champ du raisonnement médical.

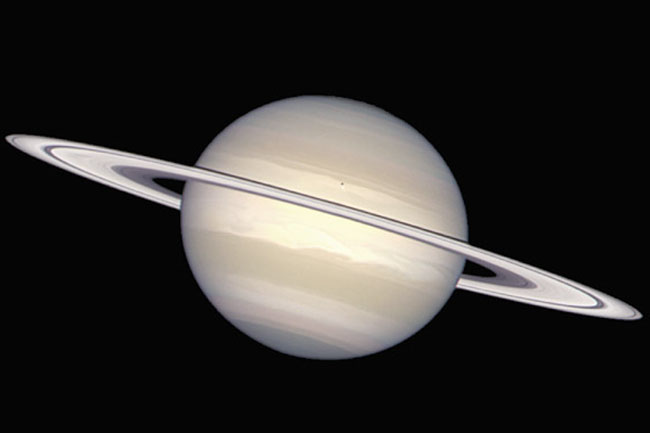

Comparer les performances humaines et celles de l’IA sur un vaste corpus de cas cliniques

Une étude publiée sur le site de preprints arXiv le 15 septembre 2025 prolonge cette réflexion. Elle a évalué la capacité de l’IA à rivaliser avec l’expertise médicale humaine en analysant des milliers de cas réels issus d’un siècle de pratique clinique.

Elle a exploité les Case Records of the Massachusetts General Hospital, publiés depuis plus d’un siècle dans le New England Journal of Medicine et qui constituent un véritable trésor pédagogique. Ces conférences clinico-pathologiques (CPC) présentent des cas authentiques, analysés par des experts qui y exposent leur raisonnement et leur démarche diagnostique. Elles ont servi de modèles à des générations de médecins pour s’exercer à l’art du raisonnement médical. Étudiant, je lisais régulièrement ces CPC, des lectures qui, des décennies plus tard, m’ont inspiré la création de ce blog dédié aux cas

cliniques rares, complexes ou hors norme.

Un siècle de cas cliniques comme terrain d’apprentissage

S’appuyant sur cette ressource unique, des chercheurs de la Harvard Medical School et du Beth Israel Deaconess Medical Center (Boston) ont compilé plus de 7 100 cas cliniques publiés entre 1923 et 2025, ainsi qu’environ 1 000 images médicales parues entre 2006 et 2025 dans le NEJM. De ce corpus est né CPC-Bench (Clinicopathologic Case Benchmark), un banc d’essai inédit destiné à mesurer la capacité des modèles d’intelligence artificielle à raisonner comme des cliniciens.

Thomas Buckley, Arjun Manrai et leurs collègues ont minutieusement annoté les CPC récentes, identifiant pour chaque cas les étapes clés du raisonnement diagnostique et les hypothèses formulées par les experts.

À partir de ce matériau, ils ont défini dix types de tâches cognitives couvrant les

principaux aspects du raisonnement médical : génération d’un diagnostic différentiel, plan d’examens complémentaires, justification des hypothèses, recherche bibliographique, interprétation d’images radiologiques ou cliniques, gestion de l’information incomplète (les données normales n’étant pas communiquées au modèle).

Parallèlement, les chercheurs ont développé Dr CaBot, une IA générative issue du modèle OpenAI o3, capable de se glisser dans le rôle d’un médecin discutant. À partir de la seule présentation d’un cas clinique, cette intelligence artificielle peut produire une analyse diagnostique complète, rédigée ou présentée sous forme de vidéo commentée, dans le style caractéristique des Case Records du NEJM.

Pour les vidéos, la narration a été générée à l’aide d’un modèle de synthèse vocale, tandis que les diapositives et la bande sonore étaient assemblées automatiquement. Afin d’humaniser le rendu, les chercheurs ont demandé à l’IA d’expliciter ses raisonnements, en intégrant même des hésitations naturelles (« euh », « hum »), comme le font les cliniciens lors de véritables conférences.

Une évaluation qui va au-delà de deviner le seul « bon diagnostic »

L’originalité et l’intérêt de cette étude résident dans sa volonté de dépasser la simple vérification du diagnostic final, longtemps considérée comme le seul critère de performance des intelligences artificielles médicales. Jusqu’ici, la plupart des évaluations se limitaient à vérifier si la machine parvenait au bon diagnostic dans sa liste de suggestions, négligeant la richesse du raisonnement déployé par les experts humains lors des CPC. Or, le rôle du médecin discutant ne consiste pas seulement à trouver la bonne réponse : il doit argumenter, justifier, interpréter, mobilisant tour à tour la physiopathologie, l’imagerie, la littérature scientifique et l’expérience clinique.

C’est précisément cette complexité que CPC-Bench permet désormais d’évaluer. Ce banc d’essai, validé par des cliniciens, mesure non seulement la capacité des modèles à générer un diagnostic différentiel, mais aussi leur aptitude à rechercher des références bibliographiques, analyser des textes médicaux et interpréter visuellement des images (radiographies, scanners, photographies cliniques) pour étayer un raisonnement diagnostique. Autrement dit, l’IA n’est plus évaluée uniquement sur son résultat final, mais sur sa cohérence argumentative et sa maîtrise des différentes sources d’information, comme le ferait un médecin face à un dossier patient complet.

Des performances impressionnantes

Les chercheurs ont évalué les performances de plusieurs modèles d’intelligence artificielle sur 377 cas cliniques. Deux critères ont été retenus : la capacité du modèle à proposer le bon diagnostic en première position (top-1 accuracy) et la présence de ce diagnostic dans les dix premières suggestions (top-10 accuracy). Outre Dr Cabot, l’évaluation a inclu Gemini 2.5 Pro (développé par Google) et Claude 4.0 Sonnet (créé par Anthropic), deux systèmes récents de génération de texte et de raisonnement avancé.

Dr CaBot s’est révélé le plus performant, plaçant le bon diagnostic en première position dans 60 % des cas et parmi les dix premiers dans 84 % des cas. À titre de comparaison, Gemini 2.5 Pro atteint 78 % et Claude 4.0 Sonnet 69 % pour la top-10 accuracy.

Ces résultats dépassent nettement ceux d’une étude antérieure conduite sur 302 cas cliniques, où vingt médecins internistes disposant d’un accès illimité à la recherche bibliographique avaient obtenu une précision de 24 % pour le diagnostic en première position et de 45 % pour les dix premières propositions. Autrement dit, Dr CaBot surpasse nettement la performance moyenne de médecins internistes, au moins sur la dimension purement textuelle du raisonnement.

L’évaluation ne s’est pas limitée au diagnostic. Les chercheurs ont également testé la capacité des modèles à recommander l’examen complémentaire le plus pertinent. Sur ce point, Dr CaBot s’est distingué avec un taux de réussite de 98 %, contre 92 % pour Gemini 2.5 Pro et 94 % pour Claude 4.0 Sonnet. L’IA ne se contente donc pas d’identifier la pathologie probable : elle sait aussi proposer l’étape suivante de l’exploration médicale en fonction des données disponibles.

Les points faibles : bibliographie et interprétation d’images

Cette supériorité n’est cependant pas générale. Les modèles d’IA demeurent fragiles dans la recherche bibliographique, peinant souvent à retrouver la source exacte d’une affirmation clinique.

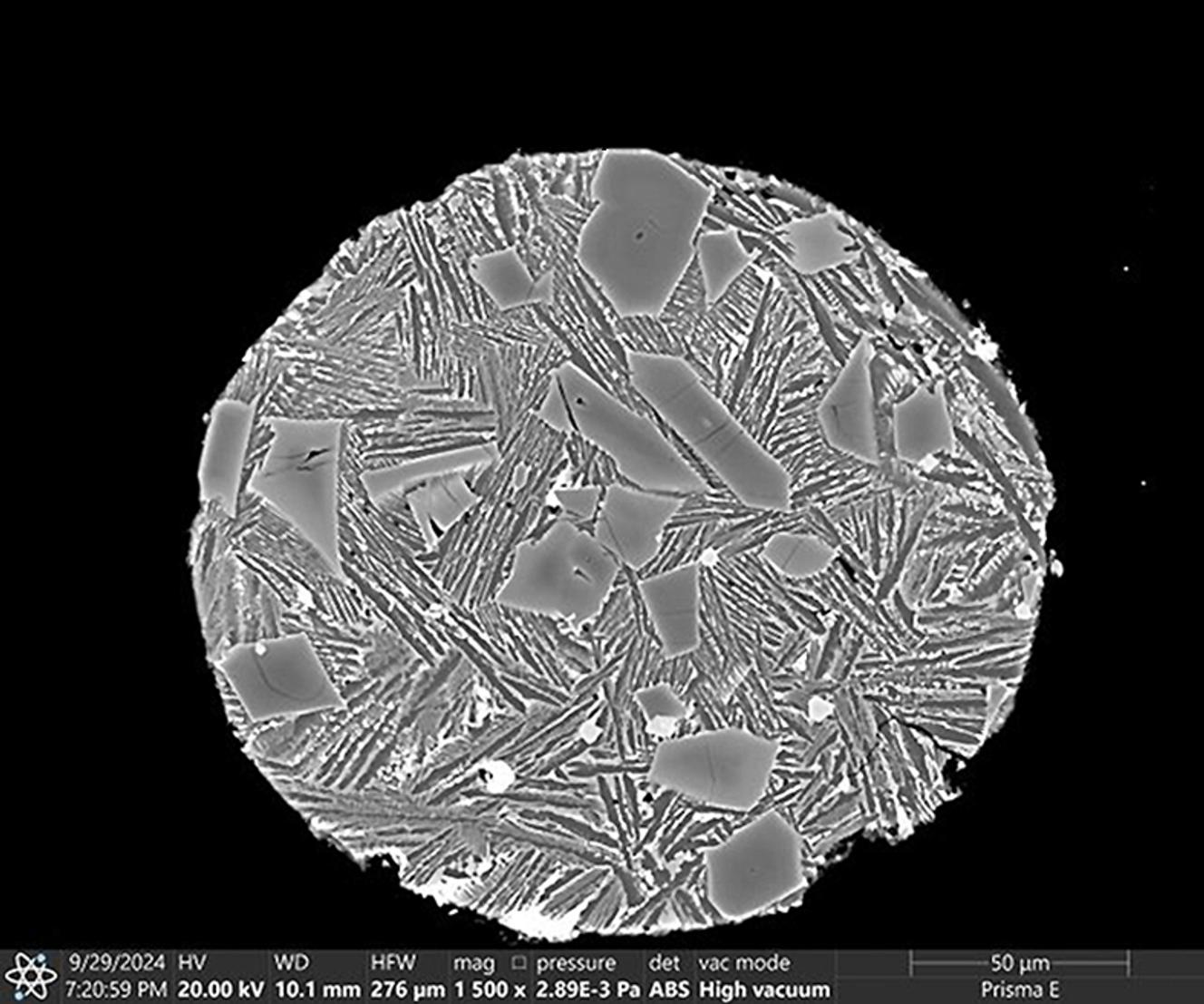

Les limites apparaissent aussi dans l’interprétation d’images médicales, évaluée à partir des célèbres quiz de la rubrique Image Challenge du NEJM (plus de 1 000 images). Dans cet exercice, Gemini 2.5 Pro arrive en tête avec 84 % de bonnes réponses, devant Dr CaBot (82 %) et GPT-4o (75 %).

Lorsque la question repose uniquement sur une image, sans texte d’accompagnement, les performances chutent nettement : 67 % de réussite pour Dr CaBot et Gemini 2.5 Pro. La spécialité joue un rôle : la dermatologie obtient de bien meilleurs scores (76 %) que la radiologie (55 %).

Sur les images directement extraites des cas cliniques CPC, les meilleurs modèles atteignent 72 % de succès en moyenne, avec de meilleures performances en histologie (exactitude de 77 % pour Dr CaBot) qu’en cardiologie (51 %). Lorsque les images sont fournies sans texte, Dr CaBot place le bon diagnostic en première position dans seulement 19 % des cas, et dans le top 10 dans 40 %.

Il reste donc des progrès à accomplir pour que l’intelligence artificielle intègre toutes les dimensions du raisonnement clinique, d’autant que lorsque certaines données normales du dossier sont omises – comme par exemple « pas de lymphadénopathie » (aucune augmentation du volume des ganglions lymphatiques) ou « scanner sans anomalie particulière » -, les performances de l’IA chutent de 4 % à 5 %. Ces informations, apparemment banales, sont pourtant essentielles dans la démarche diagnostique : l’absence de ces anomalies oriente le raisonnement tout autant que la présence de signes et symptômes cliniques.

De solides connaissances cliniques

Les chercheurs ont aussi évalué les modèles sur 1 851 questions à choix multiples (QCM), portant sur les premiers éléments du dossier d’un patient. Cette étape permet d’évaluer les connaissances cliniques des modèles.

Dr CaBot a répondu correctement dans 88 % des cas, Gemini 2.5 Pro dans 84 %, et Claude 4.0 Sonnet dans 84 % également. En revanche, le plus ancien modèle, GPT-3.5, n’atteignait que 66 %.

Ces résultats illustrent à quel point les plus récents modèles d’IA sont aujourd’hui capables de traiter efficacement des questions cliniques simples sur la base de la présentation initiale des cas.

Lors de 62 tests en aveugle, cinq cliniciens ont ensuite comparé des rapports rédigés par Dr CaBot à ceux publiés par des experts humains dans les Case Records du NEJM. Ces médecins ont été incapables de distinguer la source du texte dans près de 74 % des cas. Ils ont même jugé certains rapports produits par l’IA supérieurs sur plusieurs critères : qualité globale, justification du diagnostic, pertinence des références bibliographiques et valeur pédagogique.

Sur le texte, un raisonnement comparable à celui des cliniciens

Au total, si Dr CaBot n’a pas encore la vision intégrative d’un clinicien, il simule avec une fidélité étonnante la manière dont un médecin raisonne, écrit et enseigne. « Les grands modèles de langage rivalisent désormais avec des experts humains dans le raisonnement clinique basé sur le texte de conférences clinico-pathologiques, produisant des présentations souvent difficiles à distinguer de celles rédigées par des spécialistes », concluent les auteurs.

Selon les auteurs, la clé des progrès obtenus à ce jour ne tient pas tant à la façon de formuler les requêtes adressées à la machine, ce qu’on appelle le prompt engineering, ni même à l’entraînement sur des bases de données médicales spécialisées, mais plutôt à l’accroissement spectaculaire de la taille et de la puissance des modèles eux-mêmes.

Une ressource ouverte à la communauté scientifique

Les chercheurs de Boston n’en sont pas restés là. Ils ont mis en ligne le site cpcbench.com, permettant à tout chercheur de tester son propre modèle d’IA sur ce corpus historique et de comparer les performances obtenues. Par ailleurs, la version en ligne de Dr CaBot propose déjà des conférences cliniques vidéo et texte portant sur une quinzaine de cas publiés entre 2000 et 2025, et permet de générer de nouvelles analyses à partir de cas réels.

En résumé, Dr CaBot démontre qu’une IA peut désormais rivaliser avec les cliniciens dans les tâches de raisonnement textuel, tout en restant perfectible dès qu’il s’agit de traiter les images ou d’intégrer des informations implicites. Elle ne remplace pas le raisonnement médical, mais en reproduit la structure logique avec une précision impressionnante. Un siècle après la création des Case Records, la machine apprend aujourd’hui, dans ces mêmes pages, à raisonner comme ceux qui les ont écrites.

L’IA entre désormais dans le champ du raisonnement médical

Ces deux études très récentes, l’une publiée dans le New England Journal of Medicine, l’autre sur le site de preprints arXiv, se révèlent très complémentaires car elles explorent une même révolution : l’entrée du raisonnement clinique dans l’ère de l’intelligence artificielle.

La première, celle du patient ayant avalé un cure-dents, met en scène une confrontation inédite entre l’humain et la machine autour d’une énigme diagnostique. Elle en souligne les forces et les limites respectives : la capacité de synthèse et l’intuition clinique du médecin d’un côté ; la rapidité d’analyse et l’exhaustivité de l’IA de l’autre.

La seconde étude, publiée sur arXiv, adopte une perspective plus large. Elle dépasse le simple défi consistant à trouver le bon diagnostic final. Évaluer une IA uniquement sur ce critère ne permet pas de tester le travail accompli par l’expert humain, qui doit rédiger un diagnostic différentiel argumenté et le présenter à ses collègues spécialistes.

En développant Dr CaBot, les chercheurs démontrent qu’une intelligence artificielle peut désormais produire un raisonnement médical cohérent, aussi bien dans la rédaction d’un diagnostic différentiel que dans la présentation orale ou vidéo d’une conférence clinico-pathologique, à la manière des experts du New England Journal of Medicine.

L’IA progresse donc non seulement dans sa capacité à établir le diagnostic, mais aussi à planifier les examens, à argumenter et à rédiger, tout comme le font de véritables spécialistes.

Au final, ces deux études racontent, sous des angles différents, une même histoire : celle d’une transition historique où l’intelligence artificielle devient progressivement une alliée du raisonnement médical. Dès lors, on comprend que l’avenir du diagnostic différentiel ne se jouera pas en opposant l’humain et l’IA, mais dans leur collaboration au service du patient et de l’enrichissement du savoir médical.

[Source: Le Monde]