2025, l’année où la vidéo générée par IA a envahi les réseaux sociaux

Sur Instagram, TikTok, YouTube, X, Facebook… Impossible, pour les utilisateurs de ces plateformes, d’échapper à des flux continus de millions de vidéos générées par intelligence artificielle. Et ceux-ci en redemandent.

De faux lapins sur un trampoline. Le brainrot italien. Un coup d’Etat inventé en France. Les dernières pubs Coca-Colaet McDonald’s. Les clips de propagande de Donald Trump. Tibo InShape qui s’amuse de publications racistes qui le mettent en scène. Ces vidéos, toutes générées par intelligence artificielle (IA), ont rythmé l’actualité des derniers mois. Mais les contenus créés par IA alimentent aussi au quotidien les flux des utilisateurs de la plupart des réseaux sociaux, qui n’en ont pas forcément conscience.

Les indices sont nombreux. Au printemps, une analyse des dix chaînes YouTube les plus populaires aux Etats-Unis établissait que quatre d’entre elles postaient systématiquement des vidéos générées par IA, essentiellement musicales. En novembre, un porte-parole de TikTok évoquait le chiffre d’1,3 milliard de telles vidéos recensées sur le réseau social.

Aux origines de ce raz-de-marée : la démocratisation des outils techniques de création vidéo par IA générative. Ils se nomment Veo (lancé par Alphabet), Sora (OpenAI), CapCut (Bytedance), MovieGen (Meta) ou encore Grok (xAI), et sont directement intégrés dans les solutions d’IA grand public (Gemini, ChatGPT, Meta AI…). Avec une simple consigne écrite, ceux-ci permettent de faire des vidéos en quelques minutes – en quelques mois, leur réalisme a fait un bond en avant spectaculaire.

Or, la plupart des entreprises derrière ces technologies sont aussi celles qui gèrent les réseaux sociaux les plus populaires : YouTube, TikTok, Facebook, Instagram et X. Des groupes qui ont « besoin de prouver que l’IA a un but, et fourrent pour cela des outils dans les mains des utilisateurs », remarque Alexios Mantzaris, chercheur spécialisé en désinformation pour le site Indicator. Selon lui, la manœuvre sert à « justifier leur valorisation dopée à l’IA », alors que les doutes se renforcent sur la bulle qui pourrait menacer le secteur.

« Vendre de la publicité »

Les vidéos générées par IA sont aussi, pour ces plateformes, une occasion de récolter davantage de données personnelles. « Grâce aux prompts [les consignes décrivant le résultat souhaité] utilisés, et aux réactions aux vidéos, elles apprennent ce que leurs utilisateurs ont envie de voir, même si cela n’existe pas. Ce sont des informations précieuses », note Ioana Manolescu, directrice de recherche à l’Inria, l’Institut national de recherche en sciences et technologies du numérique. « Leur but est toujours de vendre de la publicité : tout ce qui peut retenir devant l’écran va être intéressant », ajoute-t-elle.

De fait, les outils de créations de vidéos par IA excellent à générer des formats viraux : des clips courts, jouant sur l’émotion, l’absurde ou des visuels attirants. Le Washington Post a démontré que Sora, le logiciel de création vidéo d’OpenAI, entraîné comme ses concurrents sur de large corpus de vidéos disponibles en ligne, reproduisait à merveille les types d’images qu’on trouve sur YouTube, TikTok, Twitch ou Netflix.

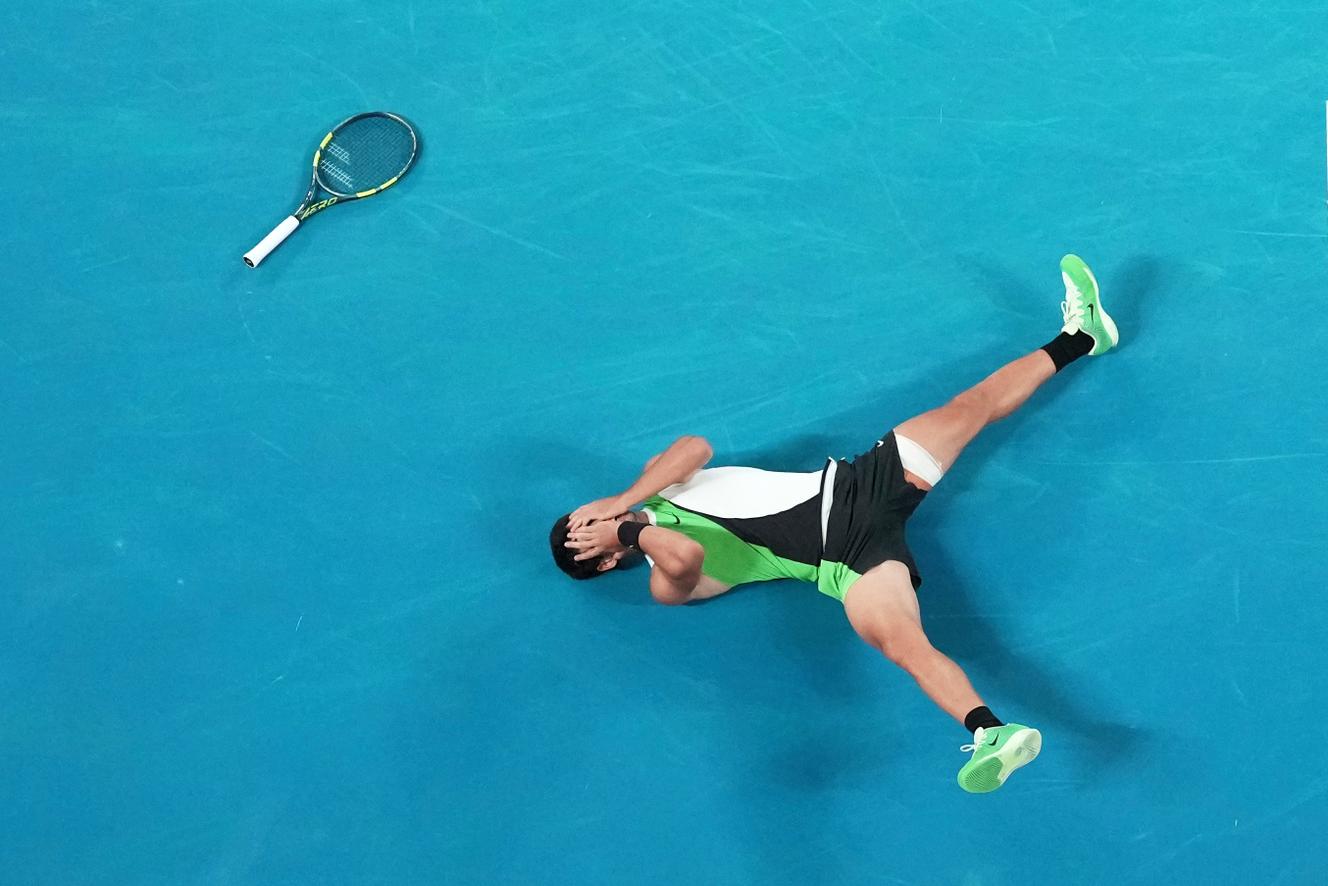

C’est pourquoi certains créateurs et diffuseurs se sont aussi saisis de cette manne. Les logiciels de création par IA leur permettent de générer parfois des dizaines voire des centaines de vidéos par jour pour un coût modique : un « slop » (média de mauvaise qualité généré par IA) calibré pour plaire à des communautés spécifiques. A l’image du compte Bonnie Rabbit, créé en Ukraine en juillet 2025, et spécialisé dans… les fausses images de terriers. En six mois, ses 56 vidéos ont été vues plus de 364 millions de fois sur Instagram, 70 millions de fois sur YouTube.

Mais le réalisme n’est pas forcément l’effet recherché par les diffuseurs, qui indiquent souvent que leurs vidéos sont artificielles. « Il y a maintenant des comptes de faux médias qui ne fonctionnent qu’avec l’IA générative. Des fausses interviews de célébrités, des faits divers improbables et imaginaires… », décrit Laurence Allard, maîtresse de conférences en sciences de la communication et chercheuse à l’université Sorbonne-Nouvelle. Elle voit dans le phénomène une certaine continuité avec la « presse de fait divers et les magazines people ». Sur Facebook, « Paul Vu » poste tous les jours des vidéos de fausses histoires avec des animaux, des personnes âgées ou dans le besoin : il est suivi par 28 millions de personnes. Dans les commentaires de telles vidéos, on trouve souvent des spectateurs conscients qu’il s’agit de créations artificielles, mais qui les apprécient quand même.

« Faits alternatifs »

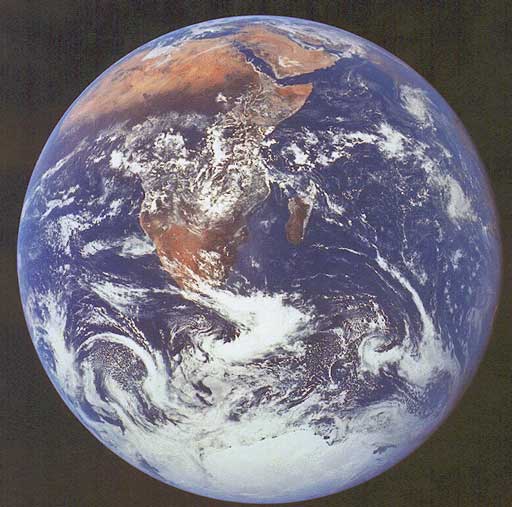

Les enjeux sont multiples, parfois vertigineux. La génération de vidéos consommerait par exemple bien plus d’énergieque toute autre requête à des logiciels d’IA générative, déjà notablement gourmands en ressources. La question du respect des droits d’auteur et des métiers de création se pose aussi, là encore. Mais toutes ces vidéos abîment également, pour Laurence Allard, notre rapport à la réalité. « Les IA permettent de générer un monde extraordinaire, qui n’existe pas, et qui se soumet complètement à des désirs. Ce sont les “faits alternatifs” de Trump qui sont exaucés », avance-t-elle.

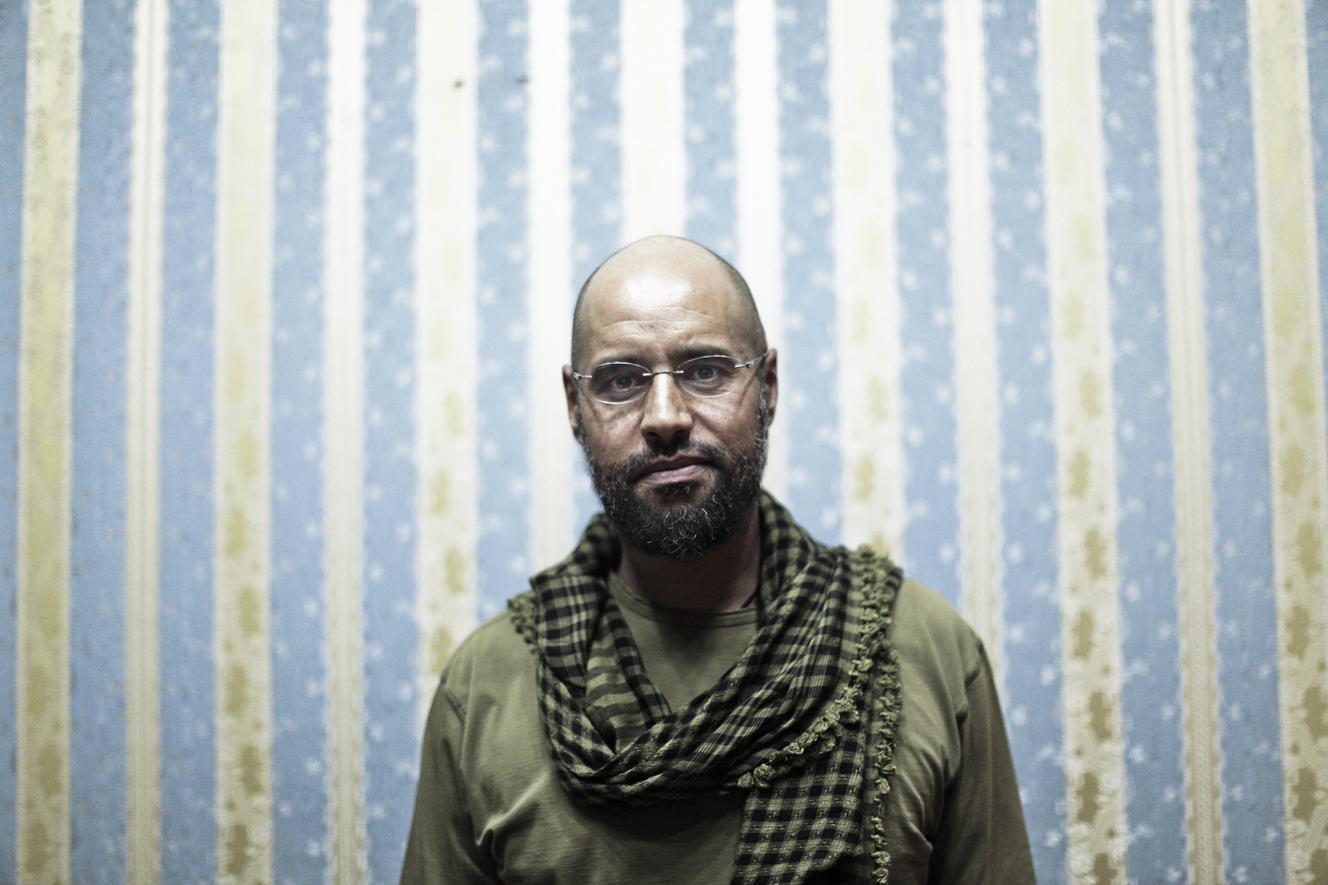

Ce « révisionnisme », voire ce « négationnisme » de la réalité selon elle, pose des « questions très problématiques en [matière] de démocratie sémiotique, et de partage d’un monde commun », continue la chercheuse. Elle note, en parallèle, que les extensions des domaines de la vidéo IA sont aussi associées aux « idéologies dont les propriétaires des plateformes sont désormais porteurs », alors qu’OpenAI, Meta, Google, X… ont toutes, d’une manière ou d’une autre, fait allégeance à Donald Trump depuis son retour au pouvoir.

Début février, le site Indicator repérait 461 vidéos générées par IA, vues plus de 700 millions de fois au total, dans lesquelles Donald Trump et Elon Musk se muaient en coachs personnels. Cette accumulation de posts servait à la fois à faire grossir des comptes, vendre du merchandising, et promouvoir les visions politiques des deux personnages.

En France, la technologie a immédiatement été adoptée, sur TikTok, par des comptes qui s’en sont servis pour diffuser des vidéos racistes. Des images qui rappellent à Ioana Manolescu des « techniques traditionnelles de propagande », mais dont la portée est désormais démultipliée.

[Source: Le Monde]